Yapay Zekânın Karanlık Yüzü: Deepfake Manzaraları Kullanan Müthiş Pedofili Ağı “ClothOff”

Yapay zekâ yoluyla istediğiniz kişinin çıplak fotoğrafını önünüze sunabilen “ClothOff” adlı uygulama, reşit olmayan birçok kız çocuğunun şantaja ve psikolojik şiddete maruz kalmasına sebep oldu. Kızların gerçek olmayan ama gerçeğinden farkı olmayan çıplak görüntüleri elden ele yayıldı.

The Guardian’ın öncülüğünde araştırılmaya devam eden konunun detaylarına inmeden önce “deepfake” dediğimiz şey tam olarak nedir ve ne gibi şeyler yapabilir bir bakalım.

Deepfake nedir?

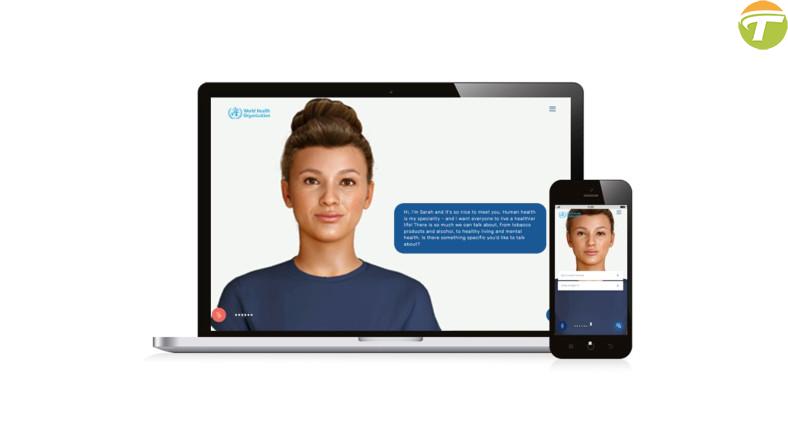

Deepfake, çoğunlukla yapay zekâ teknikleriyle oluşturulan sahte ya da manipüle edilmiş ses kayıtları, videolar ya da fotoğraflardır. Örneğin birinin videosu çok gerçekçi bir şekilde değiştirilerek videoda söylediğinden çok farklı şeyler söylüyormuş gibi yapılabilir.

Aynı şekilde sizin bir fotoğrafınız kullanılarak yapmadığınız bir eylemde bulunuyormuş ya da bir şey söylüyormuş gibi gösterilebilirsiniz. Tüm bunlar, birkaç fotoğrafın ya da videonun verileri kullanılarak kusursuz bir şekilde gerçekleştirilebilir.

Şuraya bir deepfake videosu da bırakalım:

Tek kurban Taylor Swift de değil.

Hatırlarsanız geçtiğimiz ay Taylor Swift’in deepfake görüntüleri epey gündem olmuştu. Ne yazık ki bu durum yalnızca birkaç kişinin başına gelmiyor. Bilmediğimiz şehirlerde, kasabalarda, topluluklarda; birçok insanın bu şekilde görüntüleri kullanılabiliyor.

Yani Taylor Swift buz dağının sadece görünen kısmıydı. Bizim içeriğimize konu olan dehşet verici dosya da İspanya’nın küçük Almendralejo kasabasında geçiyor.

“ClothOff” adlı uygulama, korkunç bir pedofili ağı başlattı.

The Guardian’ın 1 Mart 2024 tarihinde yayımladığı habere göre kasabadaki kız öğrencilerin yapay zekâ tarafından oluşturulan düzinelerce çıplak fotoğrafları, okuldaki diğer çocuklar tarafından kurulan bir WhatsApp grubunda dolaşıma girmişti.

Deepfake fotoğraflar yüzünden ciddi anksiyete yaşayan ve depresyona giren kızlar, okula gitmeyi bile bırakmıştı. Panik ataklar geçiriyor, şantaja ve zorbalığa maruz kalıyorlardı.

Kızlardan birinin annesi şu sözleri söylemişti: “Gördüğünüzde şoke oluyorsunuz. Görüntü tamamen gerçek gibi… Kızımın vücudunu tanımasaydım kesinlikle o görüntünün gerçek olduğunu düşünürdüm.”

Aynı durum ABD New Jersey’de de yaşanıyordu.

Almendralejo’dan binlerce kilometre uzaklıktaki New Jersey’deki bir lisede de aynı olaylar vardı. Liseli kızlar, sınıflarındaki diğer öğrenciler tarafından oluşturulan deepfake görüntülerin kurbanı olmuştu. İspanya ve New Jersey’deki olayların merkezinde ise “ClothOff” adlı aynı uygulama vardı.

Ayda 4 milyondan fazla ziyaret edilen ClothOff’a girmek için 18 yaşın üzerinde olduğunuzu onayladıktan sonra 25 görsel için 8.50 euro ücret ödemeniz yeterliydi. Bir kişinin fotoğrafını yüklediğinizde size çıplak versiyonunu veriyordu.

Korkunç pedofili ağının arkasındakiler hâlâ araştırılmaya devam ediyor.

ClothOff’un ardındaki kişiler anonim olmayı iyi bir şekilde sürdürebiliyordu ancak The Guardian’ın yaptığı 6 aylık bir araştırma, birkaç kişinin adını ortaya çıkardı. İpuçları, Belarus’ta bir erkek ve kız kardeşe götürmüştü. Şirket, paravan şirket üzerinden gelir elde ederek kara para aklıyordu.

Ulaşılan kişilerden biri ClothOff’un kurucusu olduğunu kabul etti fakat 18 yaşının altında kişilerin görüntülerinin kullanılamayacağını söyledi. Avrupa’da kayıtlı işletmeler ve Londra’daki yerleşik paravan şirketler üzerinden çalışan karmaşık bir ağ var.

Uygulamaya erişim birçok ülkeden engellendi fakat dünyanın her yerinden çeşitli yöntemlerle hâlâ kullanılabiliyor. Görüntülerin nasıl oluşturulduğu ve arkasında tam olarak kimlerin olduğu hâlâ araştırılmaya devam ediyor.

Diğer içeriklerimize göz atmak isterseniz: